Centros de datos: el sistema nervioso del Deep Learning

Rubén Rodríguez Abril

Los centros de datos modernos son el sistema nervioso del deep learning. Este artículo describe su estructura escalable: servidores especializados, racks (armarios) que los albergan, filas que gestionan flujos térmicos y salas (data halls) que integran la infraestructura completa. Se explica el recorrido de una consulta, desde la red global hasta las GPUs y viceversa, revelando la coordinación de hardware y software que hace posible la IA.

Introducción

Las grandes salas de computadores son tan antiguas como la propia informática. Los primitivos ordenadores (como ENIAC, IBM 7090 o CDC6600), que trabajaban con lámparas de vacío y utilizaban memorias de ferrita, eran albergados en salas gigantescas que a menudo contaban con sistemas de refrigeración. Conforme progresó la miniaturización de los circuitos informáticos, las grandes salas evolucionaron para albergar supercomputadores y enormes centros de datos. Hoy, esas mismas salas, base de los sistemas de IA y de Big Data, son el corazón invisible de la era digital.

No obstante, la vinculación entre los grandes centros de datos y el deep learning es relativamente reciente. El problema del desvanecimiento del gradiente impidió durante mucho tiempo la construcción de redes neuronales profundas. Por ello, incluso un hito como AlexNet, que revolucionó el mundo de la visión artificial tenía un número relativamente limitado de capa, y fue entrenado en tan sólo dos GPUs. La situación cambió con la aparición de las redes residuales (en el ámbito de la visión artificial) y de los transformers (en el ámbito del procesamiento de lenguaje natural), que permitió el escalado masivo de los modelos. Este salto tuvo un correlato inmediato en el ámbito del hardware; requirió la integración de centenares y, más tarde, miles de GPUs en centros de datos construidos ex profeso para las exigencias del aprendizaje profundo.

En este artículo ofreceremos una descripción general de los centros de datos donde se ejecutan los sistemas de aprendizaje profundo, y de manera específica los LLMs, con los que interaccionan millones de usuarios diariamente a lo largo del mundo.

Comenzaremos describiendo los principales componentes que integran un centro de datos. A continuación, analizaremos las diferentes interconexiones a través de las cuales pasa la información. En último lugar, detallaremos paso a paso el recorrido que sigue la consulta de un usuario desde que sale de su dispositivo hasta recibe la respuesta del LLM.

Componentes del centro de datos

La arquitectura física de un centro de datos moderno se organiza en una jerarquía modular y escalable. En la base se encuentra el servidor, el nodo computacional que integra CPU, GPU y memoria. Estos servidores se apilan en racks (armarios metálicos estandarizados), y los racks se agrupan en filas especializadas según su perfil térmico, eléctrico y funcional. Finalmente, las filas convergen en las salas de servidores o data halls: ecosistemas completos donde cómputo, red, energía y refrigeración se combinan para sostener cargas de trabajo masivas.

Figura 1. Varios racks (“armarios”) se agrupan en dos filas. Un aparato de ventilación se encarga de realizar tareas de refrigeración. En cada rack, los servidores se alojan en sus “estantes”. Fuente: Wikipedia.

Servidores

Son el nodo computacional fundamental en cualquier centro de datos, integrando componentes clave como CPU, GPU, memoria RAM y tarjetas NIC. Se pueden clasificar según la función que desempeñan:

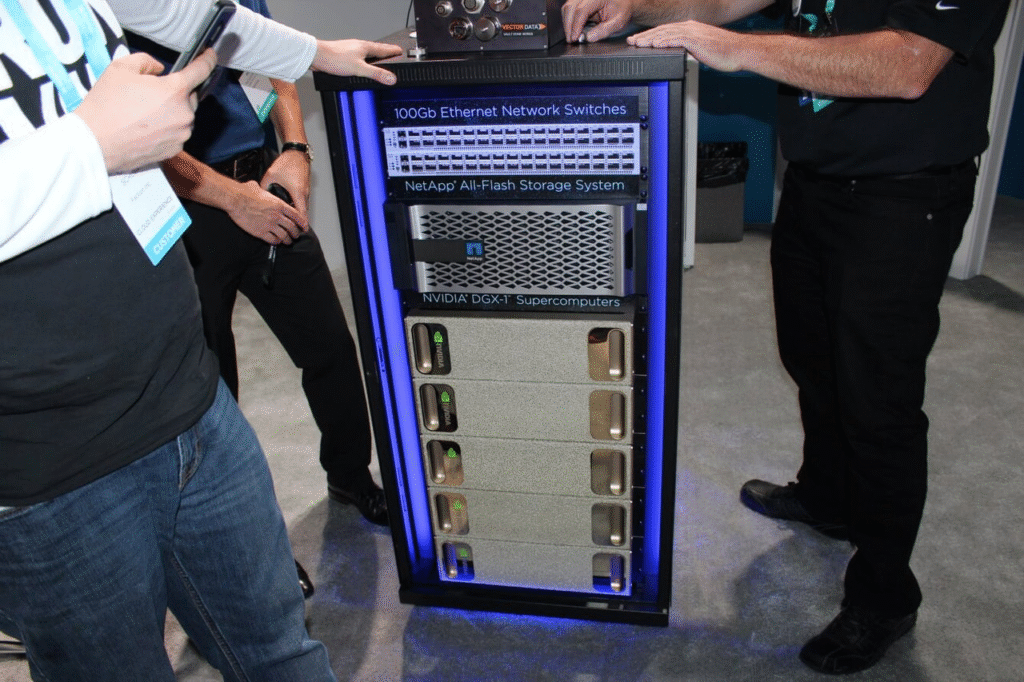

-Los servidores de entrenamiento (NVIDIA DGX H100, Google TPU, AWS Trainium…) realizan cálculo paralelo intensivo durante semanas y meses, con demandas extremas de energía y refrigeración. Típicamente se componen de 8 o más GPUs interconectadas entre sí mediante NVLink (la autopista diseñada por NVIDIA para la comunicación entre GPUs), una CPU dual y varios terabytes de memoria RAM.

-Los servidores de inferencia (NVIDIA L40S, AWS Inferentia…) se encargan de procesar las peticiones de los usuarios. Por lo general, en las LLMs se usa paralelismo de procedimiento (pipeline parallelism), lo que significa que las diferentes capas del modelo se distribuyen entre las GPUs del servidor. Los cachés KVs de las conversaciones de modelos como GPT, Gemini o DeepSeek se almacenan típicamente en las memorias HBMs de las GPUs. Estos servidores tienen una menor densidad térmica y gasto energético que los servidores de entrenamiento.

-Los servidores de almacenamiento actúan como la memoria a largo plazo del ecosistema. Su función principal es custodiar conjuntos de datos de entrenamiento, checkpoints de los modelos, logs, perfiles de usuario y metadatos preexistentes. A diferencia de los servidores de cómputo, no incorporan GPUs, ya que su prioridad no es la potencia de cálculo, sino garantizar ancho de banda suficiente para alimentar los nodos de entrenamiento o inferencia. Los datos se almacenan en decenas de discos SSD que se insertan en las bahías (slots) NVMe, que se comunican sobre conexiones PCIe.

-Los servidores de orquestación actúan como el cerebro del datacenter. Albergan el plano de control de sistemas como Kubernetes, Slurm o Ray. Su función esencial es organizar el clúster mediante programación (scheduling) de trabajos, gestión de colas y monitorización. Para estas tareas se requieren CPUs potentes y gran cantidad de RAM, pero no se necesitan GPUs. Consumen poco (0.5-1 kW), lo que permite desplegarlos en varios racks redundantes, eliminando la existencia de puntos únicos de fallo.

-Los servidores de red constituyen la frontera defensiva y operativa del data center. Se encargan de dar entrada, gestionar, filtrar y proteger las peticiones procedentes del exterior. Entre estos servidores se incluyen: routers de borde (edge), firewalls de inspección profunda, balanceadores de carga (que distribuyen el trabajo entre los nodos/servidores del panel de control), dispositivos de seguridad (IDS/IPS) y las pasarelas (gateways) de entrada.

Racks

Los servidores se alojan en armarios metálicos estandarizados de unos 2 metros de alto y 10 centímetros de ancho denominados racks o bastidores. Sus rieles internos están diseñados para albergar componentes modulares cuya altura se mide en “Unidades” o “U”, donde U = 4,45 cm. Un rack típico tiene 42U o 48U de capacidad, suficiente para apilar de 10 a 40 servidores.

Figura 2: Un rack integrado por cinco servidores NVIDIA DGX-1. Fuente: Wikipedia.

La información entre los diferentes servidores del rack es gestionada por un conmutador denominado Top-of-Rack (ToR), que como su propio nombre indica, generalmente está situada en la parte superior. A través de él pasa absolutamente todo: tanto el tráfico entre los servidores del mismo rack como el dirigido hacia servidores situados en el exterior del mismo. Cuando varios servidores cooperan ejecutando diferentes capas de un mismo LLM, tanto los tensores de inferencia como los gradientes durante retropropagación viajan entre servidores atravesando el ToR.

En la zona trasera del bastidor se sitúa la región conocida como backplane o chasis pasivo: no es una única placa base monolítica, sino un conjunto ordenado de rutas físicas, bandejas y conectores que distribuye energía, refrigeración y proporciona los caminos físicos (cables de fibra y de cobre) por donde circulan los datos.

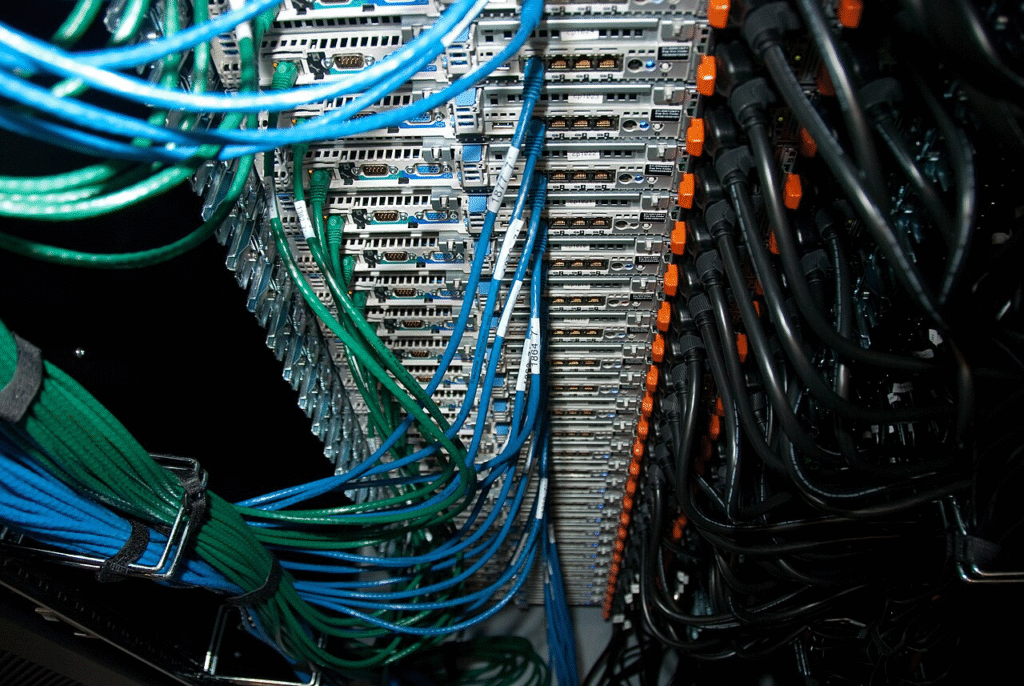

El cableado interno se clasifica en tres familias:

-cableado eléctrico, suministrado por las Power Distribution Units (PDUs) -habitualmente barras verticales- que alimentan a los servidores.

–cableado de datos, que puede ser óptico (AOC) o de cobre (DAC) y conecta a todos los servidores con ToR.

–cableado de gestión, que se utiliza para reiniciar servidores o actualizar firmware, entre otras tareas.

Figura 3. Imagen del cableado trasero de un rack de servidores de Wikimedia Foundation. Los cables de color verde y azul sirven para comunicar datos a los servidores. Los cables negros proporcionan alimentación.

Los racks de un data hall no forman una mezcolanza arbitraria sino que se agrupan por especialización de tareas y afinidad térmica:

-Los racks de alta densidad para IA (entrenamiento e inferencia) pueden demandar 30–60 kW por bastidor y requieren refrigeración extrema, en ocasiones líquida.

-Los racks de almacenamiento, cargados con decenas de SSD/NVMe, consumen menos y producen menor carga térmica.

-Los racks de control y orquestación (que alojan CPU para el plano de control) tienen un consumo mucho más moderado.

Esta diversidad se organiza en zonas homogéneas, donde cada “vecindario” comparte nivel de potencia eléctrica, tasa de disipación de calor, tipo de carga computacional, y requisitos de refrigeración.

Filas

Las filas de racks no son simples alineaciones físicas, sino módulos funcionales que organizan la infraestructura esencial del datacenter: cada fila contiene su propio cableado troncal (óptico o de cobre), sus propias unidades de distribución eléctrica (PDUs) que alimentan los racks y sus propios sistemas de contención de aire que aíslan los pasillos fríos de los calientes.

Esta estructura permite especializar zonas enteras según sus necesidades térmicas y eléctricas. Así, coexisten filas de alta densidad para GPUs (30-60 kW por rack, que requieren refrigeración líquida), filas de almacenamiento de baja potencia optimizadas para unidades NVMe, y filas de red que interconectan el clúster.

El diseño de cada fila —su orientación, climatización y calidad de la contención térmica— determina la eficiencia en la disipación de energía. Una fila mal configurada crea puntos calientes que reducen la capacidad operativa de todo el datahall, mientras que una optimizada permite alcanzar rendimientos computacionales extremos sin comprometer la estabilidad del sistema.

Salas de servidores (data halls)

Un data hall es la sala o espacio físico principal de un centro de datos donde se alojan, interconectan y operan de forma integrada todas las filas de racks de servidores, junto con la infraestructura asociada de energía, refrigeración y red.

Se organiza en zonas funcionales claramente diferenciadas:

La zona de cómputo constituye el núcleo productivo. Es aquí donde se ubican los racks GPU para cargas de IA y computación de alto rendimiento, los racks CPU para procesamiento general y los de almacenamiento. Adyacente, la zona de orquestación alberga los servidores que ejecutan el plano de control (control plane), mediante sistemas como Kubernetes o SLURM. Es el cerebro que gestiona y programa toda la infraestructura.

La estabilidad física se garantiza con zonas térmicas y eléctricas independientes. La refrigeración emplea contención de pasillos (fríos/calientes), unidades CRAC (aire acondicionado) CRAH (ventiladores que hacen pasar el aire a través de una batería de agua fría) y, para las GPU, refrigeración líquida directa. El suministro eléctrico, con rutas A/B redundantes, parte de RPPs (Remote Power Panels), se distribuye mediante PDUs de sala y PDUs inteligentes de cada rack.

Finalmente, las áreas de cableado troncal —bandejas elevadas de fibra óptica y cobre— y las zonas de seguridad e infraestructura (detección temprana de incendios, control de acceso, monitorización ambiental) completan el ecosistema. Su función es integrar y proteger el conjunto, asegurando continuidad operativa.

Flujo de la información

Debido al enorme tamaño de los modelos de Deep Learning sus diferentes capas se distribuyen entre diferentes GPUs. Los chips deben intercambiarse tensores entre sí, que pueden contener tokens de inferencia que deben pasar a la siguiente capa, gradientes que se retropropagan en sentido inverso, valores de activación, etc…

El flujo de datos sigue un patrón jerárquico y escalonado, desde la comunicación más local dentro de un servidor hasta el tráfico de largo recorrido a través del data hall.

Dentro de un servidor

La comunicación se realiza a través de buses de alta velocidad:

-NVLink, para interconexiones directas entre GPUs. Proporciona el mayor ancho de banda dentro del servidor.

-PCIe, usado para comunicación entre GPUs, CPUs y la tarjeta de red (NIC). Es la vía por la que los datos salen del servidor al exterior.

Dentro de un rack

Cuando un tensor debe viajar a otro servidor del mismo rack, la comunicación pasa a través del switch ToR (Top of Rack). El ToR agrega el tráfico de todos los servidores del rack, enruta paquetes entre ellos, y envía tráfico hacia la espina del data hall cuando es necesario. Los cables empleados (ópticos o de cobre) son similares a los mostrados en la Figura 3.

Leaf-spine: La espina dorsal del data center

A nivel de data hall todos los racks, ya sean de inferencia, entrenamiento, orquestación o almacenamiento están conectados a través de una única red física en malla, denominada leaf-spine. Como su propio nombre indica, en dicha malla hay dos tipos de nodos: Las hojas (leaves), que son los ToRs de cada rack, y la espina (spine), que viene conformada por un conjunto de conmutadores (switches) que transmiten información de un rack a otro. Este diseño garantiza: latencia constante, rutas simétricas, alto ancho de banda, y distribución homogénea del tráfico Este–Oeste (entre racks).

El leaf–spine funciona como el sistema nervioso grueso del data hall: todo dato que sale de un rack entra en un Leaf, atraviesa la Spine y regresa a otro Leaf.

Ejemplo de flujo: descarga de pesos un modelo

Supongamos que una GPU necesita cargar los pesos de un modelo. El recorrido típico sería el siguiente:

–Origen: servidor de almacenamiento. Los pesos se almacenan en servidores de almacenamiento, típicamente en unidades NVMe.

–Flujo a través del servidor. Los tensores viajan a través del bus PCIe hasta la tarjeta de red (NIC) del servidor.

–ToR del rack. Salen del servidor hacia el ToR de su rack.

–Travesía en la espina. El ToR dirige el tráfico al spine, cuyos conmutadores lo reenvían al ToR del rack de GPUs (ya sea de inferencia o entrenamiento).

–Entrega final. El ToR transmite los datos al servidor de destino. Dentro de este último, viajan desde la NIC a su GPU específica, que los carga en su memoria HBM.

Ejemplo completo: de la petición del usuario a la respuesta del LLM

Entrada desde Internet

La petición del usuario viaja cifrada a través de la red global hasta el global load balancer del proveedor (por ejemplo, OpenAI o Azure). Este último es un servicio que enruta la petición hacia la región y el clúster más adecuados según latencia, carga y disponibilidad.

Ingreso en el centro de datos

Los routers de borde del centro de datos correspondiente reciben el tráfico y lo someten a inspección mediante firewalls y sistemas IDS/IPS (sistemas de detección de intrusiones). Tras filtrarlo, la red interna del data center —mediante los conmutadores Top-of-Rack y los conmutadores de la espina (spine)— lo dirige hacia el rack asignado por el plano de control (Kubernetes, Borg o sistemas equivalentes).

Llegada al servidor de inferencia

La tarjeta de red (NIC, 100–400 Gb/s) entrega la petición a la CPU del servidor, que deserializa los datos, realiza la tokenización, y prepara los tensores de entrada. Estos se transfieren a las GPUs a través de PCIe y NVLink.

Inferencia distribuida

Las GPUs ejecutan las capas del modelo en paralelo, combinando tensor parallelism y pipeline parallelism. Las activaciones y los valores intermedios se intercambian mediante NVLink o NVSwitch dentro del servidor, y a través de la red leaf–spine cuando intervienen servidores GPU de otros racks. El KV-cache de la conversación reside en la memoria HBM de las GPUs correspondientes.

Salida hacia el usuario

Los tokens generados regresan a la CPU, donde se serializan y se encapsulan en la respuesta HTTP/HTTPS. El tráfico se enruta nuevamente a través de los conmutadores del data hall, pasa por los routers de borde y regresa por Internet hasta el navegador del usuario. Todo el ciclo suele completarse en cientos de milisegundos.

Conclusión

Figura 4. Un modelo de lenguaje, una función recursiva inteligente, se se hace operativa al encarnarse en la infraestructura física de un centro de datos.. Impresión artística de DALL-E.

Un centro de datos moderno trasciende con mucho la noción de un simple conjunto de máquinas: es un organismo integrado donde cómputo, red, energía y refrigeración cooperan con una precisión extraordinaria para sostener cargas de trabajo que exigen una sincronización extrema. Desde el tránsito interno de tensores entre GPUs hasta la ruta global que sigue una petición de usuario, cada estrato de esta arquitectura revela la complejidad física y lógica necesaria para hacer posible la inteligencia artificial contemporánea.

En este sentido, los grandes centros de datos son el auténtico sustrato material donde “habitan” los grandes modelos de lenguaje. Allí, en racks alineados en filas interminables, miles de GPUs laten al unísono mientras procesan y responden a millones de consultas humanas. Si el HAL 9000 de Arthur C. Clarke era una inteligencia centralizada, los data centers actuales son su versión distribuida: una inteligencia extendida que sostiene miles de diálogos simultáneos, silenciosa y ubicua, sustentada por una única infraestructura eléctrica, térmica y óptica.

Es allí, en esas catedrales de silicio, donde hoy reside la voz de la inteligencia artificial.

Lecturas Recomendadas

– Centro de procesamiento de datos (artículo de Wikipedia).